)

Il doppio volto dell'AI nella protezione dei dati e nella privacy

Nell'era digitale, l'intelligenza artificiale rappresenta un'arma a doppio taglio, che presenta rischi significativi e soluzioni promettenti per la protezione dei dati e la privacy. In Reply, aiutiamo i nostri clienti a chiarire le complesse interazioni dell'AI in ambito cybersecurity, per rendere organizzazioni e persone consapevoli di nuove tecniche di intelligenza artificiale considerando le rapide evoluzioni del settore.

UN'INTRODUZIONE

Qual è il ruolo dell'AI in ambito sicurezza?

Per esplorare l'impatto significativo dell'AI sulla protezione dei dati e sulla privacy, la prima sezione di questo articolo è stata interamente realizzata utilizzando strumenti di intelligenza artificiale. Quella che segue è una trascrizione esatta dei contenuti generati dall'intelligenza artificiale, basata su un semplice prompt: «Analizziamo con l'intelligenza artificiale cosa significa l'intelligenza artificiale per la sicurezza». La seconda parte dell'articolo esaminerà i risultati in modo approfondito, ponendo un'enfasi su come le tecnologie di intelligenza artificiale ridisegnano il panorama della sicurezza dei dati, della protezione della privacy e della conformità normativa in un mondo sempre più digitale.

Il testo generato dall'AI

AI: un vantaggio e una minaccia

L'intelligenza artificiale, per sua stessa natura, cerca di imitare l'intelligenza umana attraverso algoritmi complessi ed elaborazione dei dati. Questa capacità consente all'AI di analizzare grandi quantità di dati, identificare modelli e prendere decisioni con una velocità e una precisione senza precedenti. Tuttavia, proprio questa potenza dell'AI introduce anche nuove strade per le minacce informatiche.

I rischi posti dall'AI

Il potenziale dell'intelligenza artificiale per trasformare diversi settori è innegabile, ma questa tecnologia introduce anche nuovi rischi per la protezione dei dati e per la privacy. Ecco alcune delle principali preoccupazioni

Violazioni dei dati: i sistemi di intelligenza artificiale richiedono set di dati di grandi dimensioni per funzionare in modo efficace. Questi set di dati contengono spesso informazioni personali sensibili, il che li rende obiettivi per i criminali informatici. Una violazione di tali sistemi può portare all'esposizione di enormi quantità di dati personali.

Attacchi automatici: gli hacker sfruttano l'intelligenza artificiale per automatizzare e scalare i propri attacchi. Il malware basato sull'intelligenza artificiale può adattarsi alle misure di sicurezza, rendendolo più difficile da rilevare e contrastare. Ad esempio, l'intelligenza artificiale può generare e-mail di phishing altamente personalizzate, aumentando la probabilità che persone ignare cadano vittime di tali truffe.

Deepfake: la tecnologia AI può creare immagini, audio e video realistici ma falsi. Questi deepfake possono essere utilizzati per scopi dannosi, come il ricatto o la diffusione di disinformazione, complicando ulteriormente il panorama della protezione dei dati.

L'AI nelle mani degli hacker

Con l'evolversi della tecnologia, si evolvono anche le tattiche dei criminali informatici. Gli hacker utilizzano sempre più l'intelligenza artificiale per sviluppare metodi di attacco sofisticati che sfidano le tradizionali misure di sicurezza. Ecco alcuni esempi:

Phishing basato sull'intelligenza artificiale: gli attacchi di phishing tradizionali spesso si basano su messaggi generici inviati a grandi gruppi di individui. L'intelligenza artificiale, tuttavia, può analizzare i profili dei social media, le e-mail e altre attività online per creare e-mail di phishing altamente personalizzate e difficili da distinguere dalle comunicazioni legittime.

Malware adattivo: l'intelligenza artificiale consente al malware di apprendere dal suo ambiente e adattare il suo comportamento. Ciò significa che, una volta all'interno di un sistema, il malware basato sull'intelligenza artificiale può modificare le proprie tattiche per evitare il rilevamento da parte dei software antivirus tradizionali.

Advanced Persistent Threats (APT): gli hacker possono utilizzare l'intelligenza artificiale per eseguire attacchi mirati a lungo termine noti come APT. L'intelligenza artificiale aiuta questi attacchi a rimanere inosservati mentre si infiltrano nelle reti e raccolgono dati sensibili per periodi prolungati.

Il potenziale protettivo dell'AI

Nonostante questi rischi, l'AI offre anche potenti strumenti per migliorare la cybersecurity e proteggere i dati. Se utilizzata in modo responsabile, l'AI può essere un formidabile alleato nella lotta contro le minacce informatiche. Ecco alcuni modi in cui l'AI può aiutare:

AI per il rilevamento e la prevenzione delle minacce

L'intelligenza artificiale può analizzare grandi quantità di dati in tempo reale, identificando anomalie e potenziali minacce molto più velocemente degli analisti umani. Alcune applicazioni chiave includono:

Analisi comportamentale: l'intelligenza artificiale può monitorare i modelli di comportamento degli utenti e rilevare deviazioni che possono indicare una violazione della sicurezza. Ad esempio, se l'attività di accesso di un dipendente passa improvvisamente a orari o luoghi insoliti, l'intelligenza artificiale può segnalare questo comportamento per ulteriori indagini.

Sistemi di rilevamento delle intrusioni (IDS): gli IDS basati sull'intelligenza artificiale possono identificare e rispondere alle intrusioni di rete in tempo reale, riducendo al minimo i danni causati dagli attacchi informatici.

Risposta automatica: l'AI può automatizzare la risposta a determinati tipi di minacce informatiche. Ad esempio, se viene rilevata un'email di phishing, l'intelligenza artificiale può mettere automaticamente in quarantena l'e-mail e avvisare l'utente, riducendo il rischio che venga aperta.

AI nella protezione dei dati

L'AI può anche svolgere un ruolo cruciale nella salvaguardia dei dati personali:

Crittografia dei dati: l'intelligenza artificiale può migliorare le tecniche di crittografia dei dati, rendendo più difficile l'accesso alle informazioni sensibili da parte di soggetti non autorizzati.

Controllo degli accessi: l'intelligenza artificiale può gestire l'accesso ai dati valutando continuamente il livello di rischio degli utenti e regolando le autorizzazioni di conseguenza. Ciò garantisce che solo le persone autorizzate abbiano accesso alle informazioni sensibili.

Mascheramento dei dati: l'intelligenza artificiale può mascherare i dati sensibili in ambienti non di produzione, consentendo alle organizzazioni di utilizzare dati reali per test e sviluppo senza compromettere la privacy.

In che modo Reply può aiutarti

In Reply, comprendiamo le complessità legate alla doppia natura dell'AI nella sicurezza informatica. Il nostro team di esperti è dedicato a sfruttare l'Ai per fornire solide soluzioni di protezione dei dati mitigando al contempo i rischi associati. Ecco come possiamo aiutarti:

Valutazione completa del rischio: conduciamo valutazioni approfondite del rischio per identificare potenziali vulnerabilità nei vostri sistemi di intelligenza artificiale e raccomandare misure per affrontarle.

Soluzioni di sicurezza basate sull'intelligenza artificiale: sviluppiamo e implementiamo soluzioni di sicurezza basate sull'intelligenza artificiale su misura per le tue esigenze specifiche, migliorando la tua capacità di rilevare, prevenire e rispondere alle minacce informatiche.

Monitoraggio e supporto continui: i nostri servizi includono monitoraggio e supporto continui per garantire che i tuoi sistemi rimangano protetti dalle minacce in evoluzione.

Programmi di formazione e sensibilizzazione: offriamo programmi di formazione per istruire il personale sulle ultime minacce basate sull'intelligenza artificiale e su come mitigarle. La consapevolezza è una componente cruciale di una solida strategia di sicurezza informatica e la nostra formazione garantisce che il tuo team sia ben preparato a gestire potenziali minacce.

Soluzioni AI personalizzate: riconoscendo che ogni organizzazione ha esigenze uniche, sviluppiamo soluzioni di intelligenza artificiale personalizzate per affrontare le tue specifiche sfide di sicurezza. Che si tratti di migliorare la crittografia dei dati, implementare sistemi avanzati di rilevamento delle minacce o sviluppare protocolli di risposta automatici, le nostre soluzioni su misura garantiscono una protezione completa.

Conclusioni

In conclusione, l'intelligenza artificiale presenta sfide significative per la protezione e la privacy dei dati, ma offre anche potenti strumenti per contrastare queste minacce. Collaborando con i nostri esperti, le organizzazioni possono sfruttare il potere protettivo dell'AI proteggendosi al contempo dai rischi. Insieme, possiamo navigare in questo panorama complesso e garantire un futuro digitale sicuro.

La duplice natura dell'intelligenza artificiale nella sicurezza informatica richiede un approccio equilibrato. Mentre continuiamo a innovare e sviluppare tecnologie di intelligenza artificiale, dobbiamo rimanere vigili sui potenziali rischi e cogliere al contempo le opportunità che presentano. Promuovendo la collaborazione tra sviluppatori di intelligenza artificiale, esperti di sicurezza informatica e organizzazioni, possiamo creare un ambiente digitale più sicuro per tutti.

In Reply, ci impegniamo a guidare queste iniziative, fornendo soluzioni di sicurezza all'avanguardia basate sull'intelligenza artificiale che consentono alle organizzazioni di proteggere i propri dati e la propria privacy in modo efficace. Mentre andiamo avanti, la nostra attenzione rimane sull'innovazione, l'adattabilità e l'eccellenza nella sicurezza informatica, assicurandoci di stare al passo con le minacce in evoluzione e di continuare a fornire una protezione senza precedenti ai nostri clienti.

Le conclusioni

Una panoramica di ciò che l'AI ha generato

Come possiamo notare, l'AI ha funzionato perfettamente, creando un articolo che mostra esattamente cosa è utile per comprendere i rischi informatici e le potenzialità dell'AI: abbiamo avuto un ottimo esempio delle sue potenzialità.

Ma c'è anche qualcosa di preoccupante al riguardo. Non è del tutto chiaro da dove provengano queste informazioni, né dai dati di addestramento del modello di intelligenza artificiale né dai dati personali a cui ha accesso. E nel caso in cui lo strumento di intelligenza artificiale in uso sia connesso a un sito web esterno (non era il nostro caso, ma è un caso d'uso comune), potrebbe essere stato «avvelenato» da informazioni errate o pericolose, potrebbe essere stato infettato da malware, potrebbe aver utilizzato e quindi esposto dati personali e sensibili dell'utente a cui ha accesso. In generale, significa che per utilizzare l'AI in ogni aspetto della nostra vita, e soprattutto quando significa toccare il mondo fisico, dobbiamo mettere in atto una serie di controlli che possano certificare i risultati dell'AI, verificare che tutti i livelli di sicurezza siano rispettati e che il risultato sia in linea con le policy, i regolamenti e i valori etici delle nostre aziende e della nostra società.

Questa convinzione fondamentale è alla base dell'approccio di Reply all'AI, che garantisce che tutte le iniziative all'interno dell'organizzazione aderiscano a linee guida etiche, con particolare attenzione allo sviluppo di un'AI responsabile e alla collaborazione con gli stakeholder esterni.

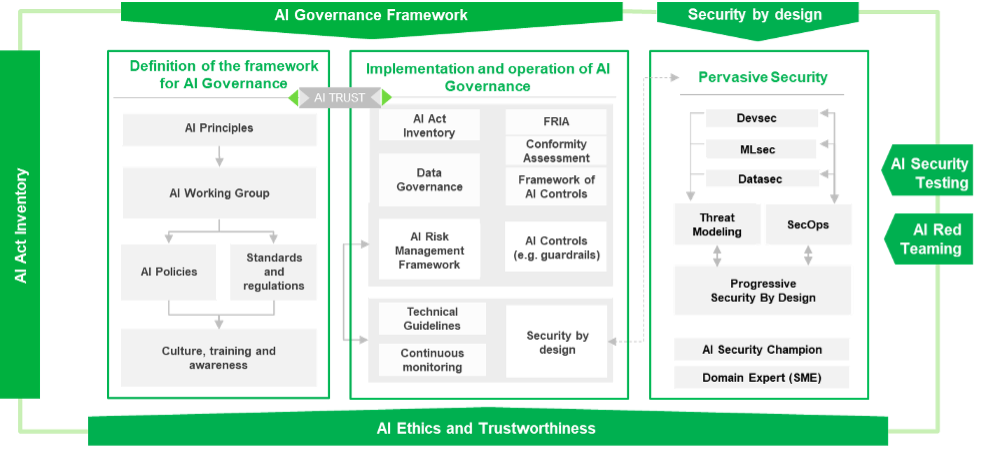

Sicurezza per l'AI

Sulla base di questi principi etici, gli esperti di security di Reply hanno sviluppato un framework completo di AI Security Governance and Compliance per gestire la configurazione e le operazioni dei sistemi di AI, con controlli e strumenti di cybersecurity per proteggere dati e utenti.

La configurazione dell'AI Framework è un passaggio fondamentale da pianificare come azione a breve termine, considerando due fattori principali.

Il primo fattore è che i casi d'uso dell'AI attualmente presenti sul mercato stanno uscendo dalla sfera dell'innovazione e diventeranno molto presto vere applicazioni di produzione. Stanno infatti utilizzando dati reali anche su questi casi d'uso iniziali, costituendo già una grande preoccupazione per CISO e CSO, e rappresenteranno un rischio crescente una volta che saranno ampiamente utilizzate dai clienti finali e diffuse nel complesso ambiente digitale presente in ogni azienda.

L'analisi e la protezione dei rischi informatici legati agli strumenti e alle tecniche di intelligenza artificiale saranno quindi un elemento chiave per proteggere gli investimenti, con le organizzazioni di cybersecurity che svolgeranno un ruolo chiave nell'adozione dell'AI.

Il secondo fattore è legato all'AI Act Compliance, che richiede l'adozione di un'organizzazione e di processi dedicati per analizzare e classificare ogni utilizzo dell'AI in azienda. Le principali responsabilità saranno a carico delle aziende che utilizzano sistemi di intelligenza artificiale ad alto rischio, ma ciò significa che ogni azienda deve tenere traccia di tutti gli utilizzi dell'AI, realizzare l'AI Inventory, definire principi e politiche e classificare i sistemi di intelligenza artificiale in uso.

L'approccio proposto da Reply è su misura, ovvero volto a progettare e implementare un framework specifico e focalizzato sul contesto aziendale, e specificamente integrato nelle tassonomie e metodologie già definite e applicate dalle organizzazioni di Compliance e cybersecurity.

AI per la sicurezza

Oltre alle attività necessarie per proteggere gli strumenti e i dati dell'AI, la cybersecurity potrebbe beneficiare della potenza dell'AI. Per sfruttare appieno questa opportunità, è fondamentale sapere molto bene come utilizzare gli strumenti di intelligenza artificiale per ottenere risultati, riducendo al contempo i rischi e applicando tutti i controlli pertinenti.

Per questo motivo, Reply utilizza l'intelligenza artificiale per sviluppare agenti di sicurezza, allenati su due aree in cui sono presenti le principali esigenze per attività e processi legati alla sicurezza: un Software Development Life Cycle sicuro, con agenti di intelligenza artificiale che supportano il team di sviluppo per introdurre requisiti e test di sicurezza con un approccio shift-left, e gli agenti a supporto del regolamento DORA.

Il regolamento DORA è un buon esempio di come l'AI possa essere utilizzata per supportare le organizzazioni di security e compliance, con un'attenta selezione di agenti specializzati e adeguatamente formati che possono aiutare a semplificare i processi di analisi dei documenti e dei contratti necessari per la compliance e che richiedono diverse persone qualificate per essere completati.

Nella scelta delle funzionalità da implementare con questi agenti, Reply adotta un attento equilibrio tra innovazione, reali esigenze di processo e vincoli normativi. Il nostro obiettivo è garantire che le soluzioni che sviluppiamo non solo superino i limiti delle capacità tecnologiche, ma soddisfino anche i requisiti aziendali pratici e siano conformi agli standard e alle normative esistenti. Questo approccio ci consente di creare tool basati sull'intelligenza artificiale che siano allo stesso tempo all'avanguardia e pragmatici, in grado di offrire un valore reale mantenendo un elevato livello di fiducia e sicurezza.

Spike Reply è specializzata in consulenza sulla sicurezza, integrazione di sistemi e operazioni di sicurezza e supporta i propri clienti dallo sviluppo di programmi di gestione del rischio in linea con gli obiettivi strategici aziendali, alla pianificazione, progettazione e implementazione di tutte le misure tecnologiche e organizzative corrispondenti. Grazie a un'ampia rete di partnership, seleziona le soluzioni di sicurezza più appropriate e consente alle organizzazioni di migliorare il proprio livello di sicurezza.

;Resize,width=660)

,allowExpansion;Resize,width=660)

,allowExpansion;Resize,width=660)

;Resize,width=660)

,allowExpansion;Resize,width=660)